Table des matières

Le « True Peak » (TP) ou « Crête Vraie », noté aussi « Intersample Peaks » (ISP), également désigné sous le terme « Intersample Peaks » (ISP), constitue une notion qui n’est pas toujours bien comprise aujourd’hui dans le monde de la Production Musicale. Depuis l’émergence des plateformes de Streaming dans les années 2010 et des pratiques amateures « Home Studio » devenues très courantes, le sujet du True Peak revient en force, malgré qu’il ait toujours existé depuis l’éclosion de l’audionumérique à travers le support CD qui s’impose dès 1982. Dans le milieu de l’enregistrement sonore lié à la production musicale, le True Peak n’a d’intérêt qu’au au stade du Mastering, lorsqu’un fichier « audionumérique » est finalisé avant d’être diffusé.

Qu'est-ce que le "True Peak" ?

Dans un fichier audionumérique le True Peak désigne la représentation des niveaux continus quand ils dépassent la valeur d’échantillons voisins. Il représente un niveau analogique réel quand il dépasse le niveau de 2 échantillons successifs, lors de la conversion du signal numérique en signal analogique (DAC) :

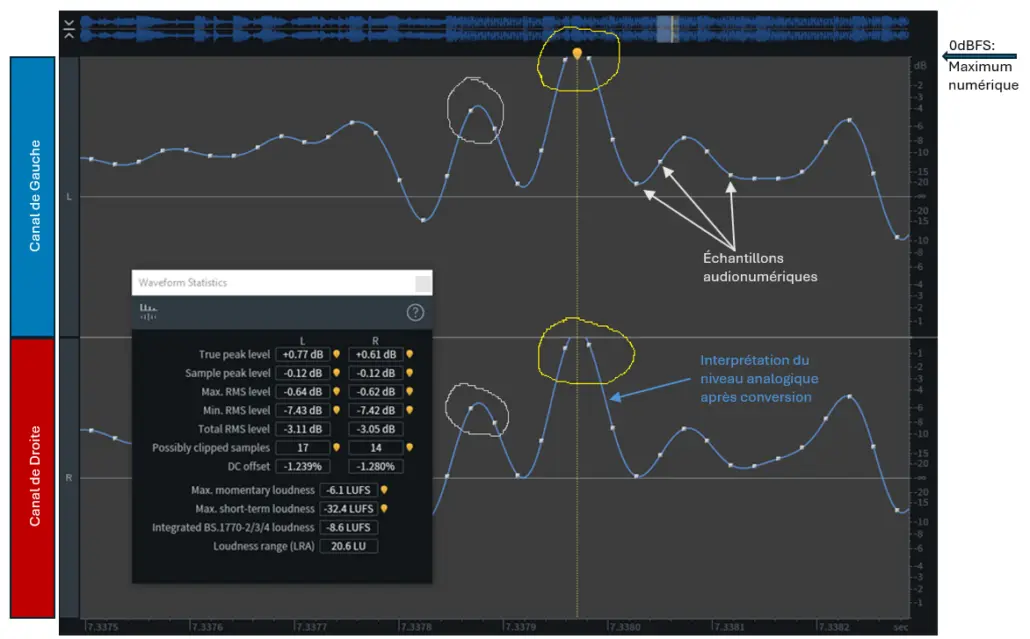

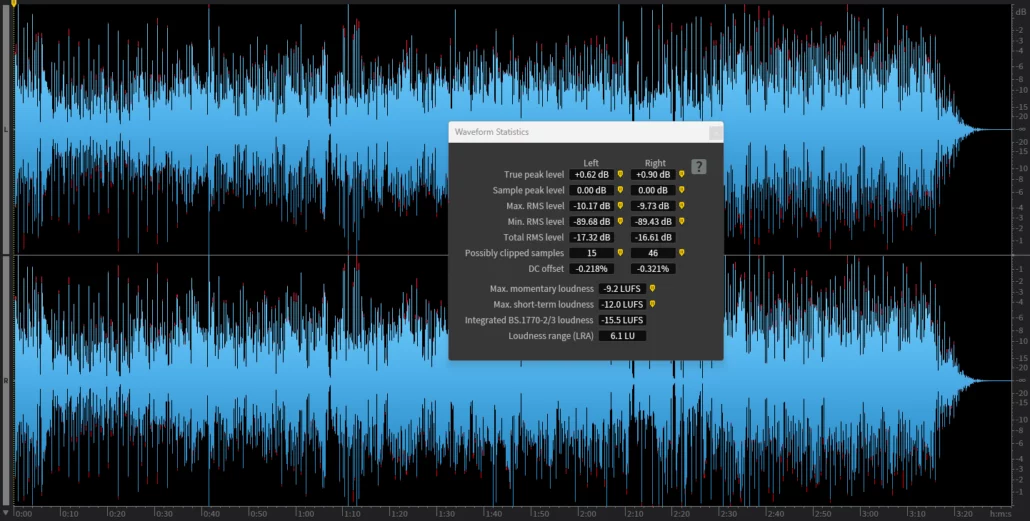

Figure 1 : Analyse d’un fichier audionumérique. Sur la sélection. En jaune : niveaux True Peak (TP) crées par deux échantillons successifs possédant des valeurs proches du maximum numérique (le Full Scale / 0dBFS). Sur l’ensemble du morceau analysé : sur le canal de gauche (en haut) le niveau TP atteint +0.77dBFS, sur le canal de droite (en bas) le niveau TP atteint +0.60dBFS. Le logiciel indique 17 valeurs TP « dépassant le 0 » sur le canal de gauche, et 14 valeurs TP « dépassant le 0 » sur le canal de droite.

En gris clair : nous observons aussi des niveaux True Peak sur les 2 canaux, mais ceux-ci n’ont aucune incidence car leur niveau est compris dans l’échelle Full Scale. (logiciel: iZotope RX)

Le True Peak est une notion propre au codage LPCM, ce dernier étant utilisé en Production Musicale à travers les outils informatiques qui permettent aux ingénieurs du son d’enregistrer, de modifier ou de créer des sons. À ce stade, il convient aussi de rappeler qu’il existe un deuxième type de codage audionumérique, le DSD. Or, pour celui-ci la notion de True Peak est inapplicable. Nous verrons la raison à la fin de l’article, lors d’un chapitre dédié.

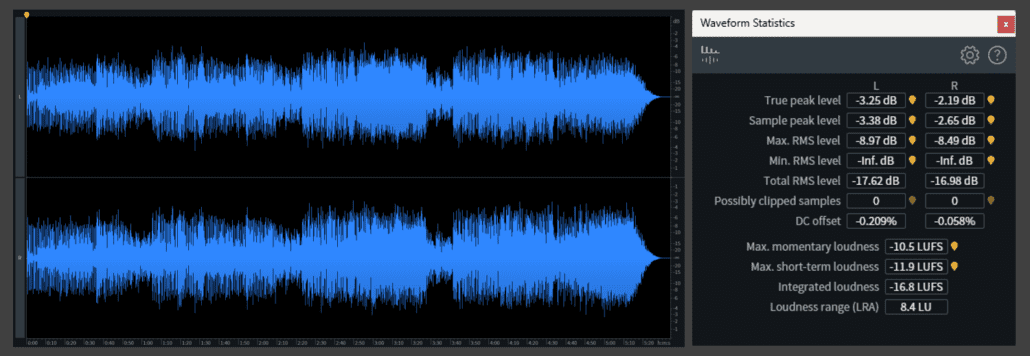

Les valeurs True Peak n’informent pas sur le « niveau global » du fichier audio enregistré. D’autres mesures représentant le niveau « moyen » sont plus utiles pour repérer le niveau de l’enregistrement que nous percevons. Il s’agit du niveau « RMS » ainsi que d’un autre type de niveau qui fait appel à une mesure plus élaborée: le « Loudness Intégré » (Integrated Loudness) (cf Figure1 : Integrated BS.1770 Loudness). Le volume « RMS » (cf Figure 1 : Total RMS level) indique la moyenne arithmétique qui est défini par la forme d’onde représentée en codage LPCM. Cette valeur représente donc en quelque sorte « la moyenne » du signal enregistré. Elle s’exprime dans l’échelle numérique courante, en décibel « Full Scale » (dBFS), qui de surcroît est négative et dont la valeur maximum est fixée à « 0 ». Aujourd’hui les studios utilisent une méthode de calcul plus récente qui permet d’affiner la valeur « RMS » dans une échelle numérique semblable, le LUFS (Loudness Unit relative to Full Scale) mais dont l’algorithme de calcul, plus élaboré, tient compte du comportement de l’oreille humaine en fonction des fréquences et des intensités perçues (Courbe isotonique, Travaux de Fletcher & Manson, 1933). Par conséquent pour un morceau de musique donné, c’est la mesure de la valeur du « Loudness Intégré » qu’on utilisera pour définir le niveau « moyen » de l’enregistrement, et non pas la valeur RMS, et encore moins les valeurs maximales de True Peak qui ne peuvent donner aucune indication sur le niveau global enregistré.

Dans le domaine de l’audionumérique le True Peak concerne n’importe quel fichier multicanal LPCM voué à être lu via un système de diffusion sonore. Aujourd’hui la notion de True Peak refait surface dans les studios en raison notamment du développement des Plateformes de Streaming et des « recommandations » données par celles-ci à destination des studios de Mastering, mais cette notion reste invariable depuis l’invention du LPCM qui concerne toute forme de fichiers voués à être lu, comme par exemple le Cd-Audio. En effet, dans le cas d’une musique Stéréo qui comporte deux canaux (gauche et droit), il existe un double flux de données numériques qui représente la lecture de deux formes d’ondes distinctes pour chaque côté. Ce double flux numérique se transforme en un double signal électrique séparé qui est transmis à une paire d’haut parleurs. Selon les performances du système de reproduction le fichier lu est restitué plus ou moins fidèlement. Par conséquent, la musique que nous percevons à travers un matériel de lecture donné peut énormément varier dans la qualité de reproduction, en comparaison avec le fichier initial dans la manière où l’artiste, le Producteur et l’ingénieur du Son l’a créé. Outre les critères plus évidents comme la restitution fréquentielle des sons, la dynamique, ou la précision dans la localisation des instruments dans l’espace sonore, demeurant très dépendante de chacun des éléments du système, le True Peak quand à lui peut poser un problème au niveau du tout premier maillon de la chaîne. Il peut également suggérer d’autres soucis dans la manipulation du fichier.

Les conséquences défavorables du "True Peak"

Quand les valeurs True Peak dépassent certains seuils de niveaux et selon les différents cas d’usage qui se présentent comme nous allons le voir, la conséquence peut être problématique au moment de l’utilisation du fichier audio.

Comme nous l’avons vu, les niveaux True Peak ne donnent aucune indication sur la Sonie d’une musique enregistrée, ils révèlent juste une représentation de la continuité possible et réelle du signal analogique lors de la lecture du fichier. Cependant il arrive que le niveau analogique se traduisant entre deux échantillons successifs, puisse dépasser la valeur numérique maximale (le Full Scale).

La surcharge du DAC

Cette notion de True Peak est importante à comprendre car elle peut engendrer de mauvaises conséquences au moment la lecture de la musique quand celle-ci provient d’un format numérique. Aujourd’hui avant d’envoyer les Masters sur le marché, les valeurs True Peak sont évaluées et parfois contrôlées par les ingés-son des studios qui réalisent le Mastering du projet musical. Au moment de finaliser les derniers traitements numériques du signal sur la musique qu’on leur confie (les mixages) les ingés-son Mastering sont capables d’ajuster correctement ces niveaux de transition « numérique vers analogique » afin d’éviter toute forme de distorsion audible qui pourrait apparaitre à travers les systèmes de lecture des utilisateurs.

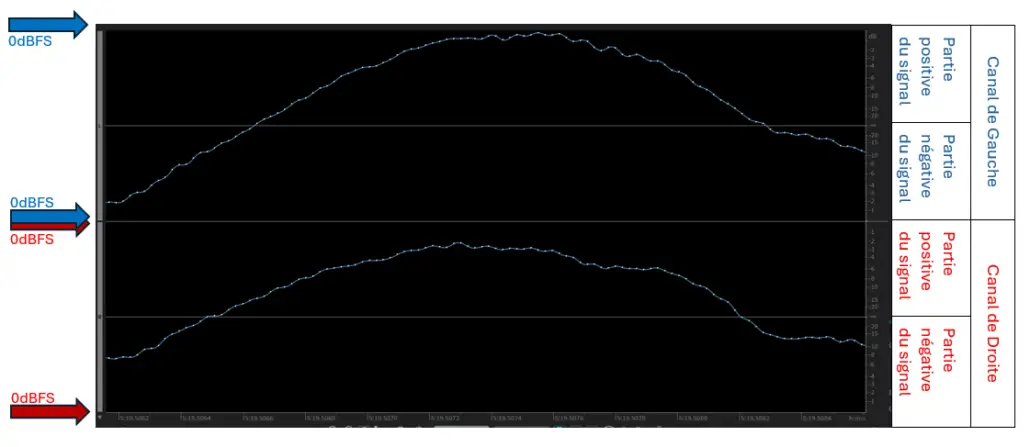

Dans n’importe quel fichier audio dans lequel une musique est enregistré, tous les échantillons du signal sont légitimes car ils demeurent in facto définis dans la zone des valeurs de l’échelle numérique. Ils résident dans la partie positive du signal ainsi que dans la partie négative du signal, donc en dessous du 0dB Full Scale des deux côtés de la Forme d’Onde (waveform), Cf Figure 2:

Figure 2 : représentation stéréo de deux formes d’onde numérisées, correspondant aux deux canaux gauche et droit.

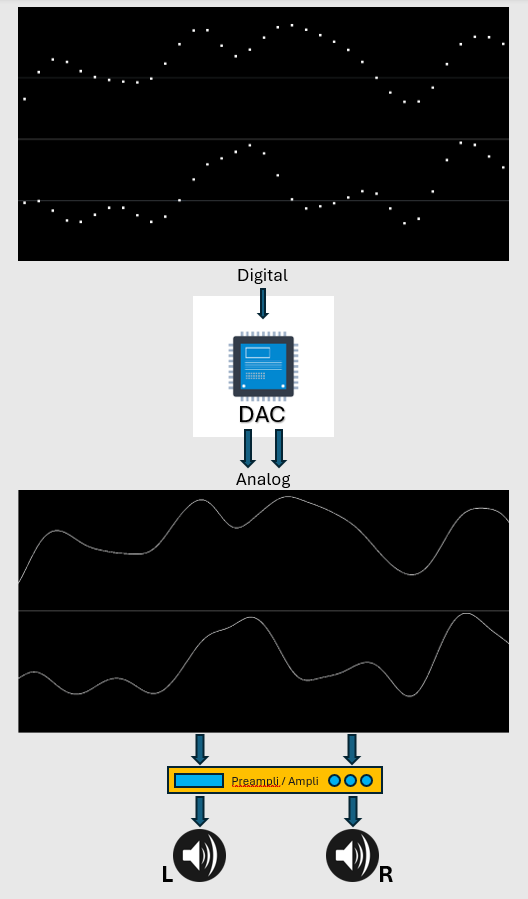

Afin d’être entendu au moyen de transducteurs (hauts parleurs ou casques), tout signal audionumérique subit une conversion « numérique vers analogique » au moment de la lecture. Le circuit électronique complexe qui est responsable de ce passage de domaine se nomme un DAC (Digital to Analog Converter) encore noté CNA (Convertisseur Numérique vers Analogique). Le rôle d’un DAC est de transformer les valeurs discrètes des échantillons en un courant électrique continu. Lequel, plus loin dans la chaîne est amplifié avant d’être transmis à un système de Haut Parleurs. Les transducteurs transforment le courant électrique en énergie mécanique, ce qui explique le mouvement de la membrane du Haut Parleur et donc la perception du Son (Figure 3).

Figure 3 : Le signal audionumérique LPCM est envoyé sur le DAC pour être converti en signal éléctrique analogique qui par définition forme un signal continu. Ce signal est ensuite amplifié pour être transmis jusqu’aux Hauts Parleurs.

Au sein du DAC, si la représentation analogique dépasse le niveau correspondant au maximum numérique (0dBFS) à gauche ou à droite dans une partie positive ou négative du signal, le DAC se voit chargé de reproduire un niveau analogique dont l’équivalent numérique n’existe pas. Par conséquent le convertisseur DAC écrête (clippe) à cet endroit. En effet, une forme de distorsion ponctuelle se crée: les valeurs de tous les échantillons sont traduites selon les capacités et les performances du DAC, mais le signal analogique généré présente forcément des erreurs de conversion à cause des valeurs True Peaks franchissant la limite numérique. Habituellement cette distorsion n’est pas intentionnelle. Elle ne fait, en principe, aucunement partie des souhaits de l’artiste, du producteur, ou du technicien en charge de produire le Master.

D’où, en théorie, l’importance de créer des Masters atteignant des niveaux True Peak contrôlés afin que les DACs puissent traduire des niveaux continus sans introduire ce genre de distorsion.

Sauf qu’en pratique, c’est selon la qualité des systèmes de reproduction sonore, en l’occurrence la performance des DAC, que cette distorsion est plus ou moins importante et donc de surcroît plus ou moins audible. C’est au travers des DAC « bas de gamme » que la distorsion engendrée est la plus grande. Et à l’inverse, sur les systèmes professionnels ou audiophiles les plus aboutis, cette distorsion est pratiquement inaudible grâce à l’utilisation de DACs beaucoup plus performants. Notamment les DACs qui utilisent, entre autre, la technologie du codage Delta Sigma que l’on retrouve dans le DSD.

Tous les DAC ne se valent jamais car leur conception électronique peut demeurer très différente d’un modèle à un autre. Les convertisseurs les plus sérieux du Marché sont réalisés avec des composants de qualité maximale, lesquels sont également triés sur place avant d’être retenu puis soudés. Pour élaborer un DAC il existe plusieurs méthodes: elles sont liées aux différentes technologies disponibles, aux astuces d’ingénierie et aussi au coût des composants.

Pour représenter une idée du marché dans le domaine de la Hi-Fi j’ai dressé une liste non exhaustive en parcourant les sites d’achat. On trouve des DACs externes à 15€ comme 1er prix (a). Fort heureusement il existe des DACs plus élaborés valant quelques centaines d’euros (exemple à moins de 200€ (b). Les prix peuvent grimper jusqu’à plusieurs milliers d’euros (c et d) donc, pour cette « seule » fonction de pouvoir convertir à la volée deux signaux audionumériques (gauche et droite) en deux signaux analogiques correspondants.

a. DAC portable d’entrée de gamme, Jade Audio JA11, source Son-Video.com

b. DAC standard Topping Audio DX3Pro+, source Topping Audio

c. DAC audiophile Atoll DAC300, source cta-hifi.com

d. DAC Haut de gamme McIntosh MDA200, source Elecson

Il en va de soi de comprendre que la qualité de la reproduction d’un signal numérique est absolument tributaire de la qualité du DAC utilisé, au même titre que la qualité de l’amplificateur et de la paire d’enceintes utilisée. Le DAC est un élément important et généralement très sous-estimé du grand public. Je vous met au défi de réaliser des comparaisons, si un jour vous en avez l’occasion.

Pour résumer, pendant la lecture des fichiers audionumériques, la gestion des True Peaks se réalise uniquement au sein d’un DAC. La qualité de ce dernier est déterminante dans sa capacité à gérer les valeurs True Peaks quand ces derniers dépassent la valeur maximale de l’échelle numérique.

Les codecs Lossy

D’une manière générale un codec audio est un dispositif algorithmique qui fonctionne en deux parties: l’encodeur et le décodeur. Dans ce Blog nous ne nous intéresseront uniquement aux codecs dits « Lossy », ceux qui au moment de l’encodage génèrent une perte d’information audible en échange d’un poids numérique du quelques mégaoctets seulement. En effet comme les autres Codecs dits « Lossless » présentent le même signal qu’au départ après décompression, les valeurs True Peak restent les mêmes. Par conséquent il n’y a aucun intérêt de s’intéresser ici aux transformations Lossless.

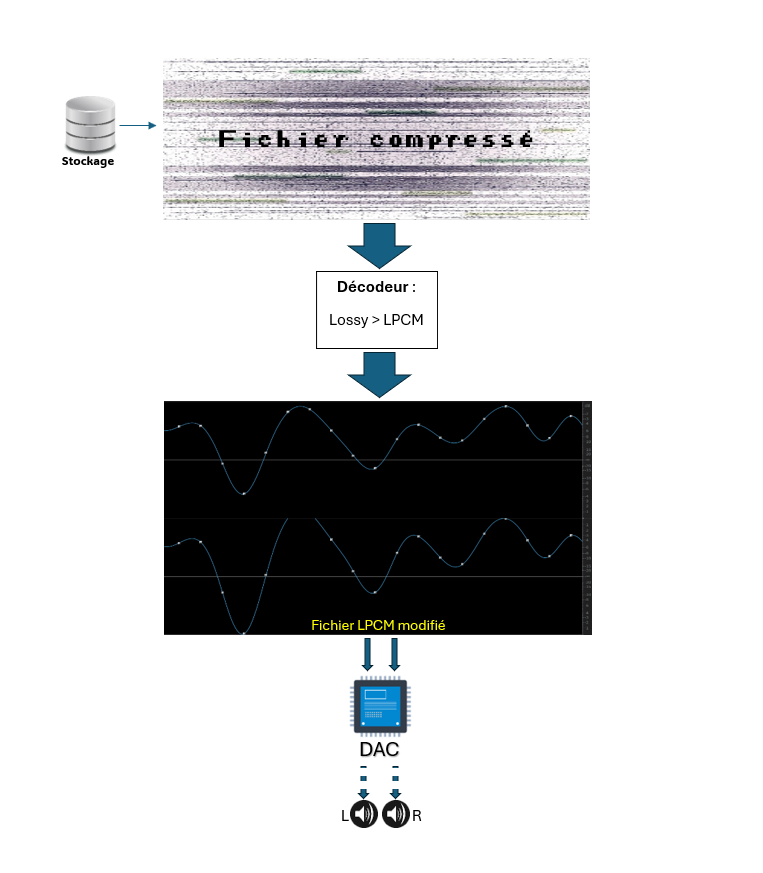

On transforme donc le signal du Master de départ, codé en LPCM, vers un signal d’arrivée par compression de données « avec Perte ». C’est le principe de l’encodage. Les fichiers LPCM provenant des studios de Mastering (extensions .wav, .aiff) peuvent à tout moment être encodés vers des fichiers de formats différents pour alléger leur poids, comme dans le cas du mp3, de l’AAC, de l’Ogg Vorbis ou du WMA… Le nouveau fichier est ainsi stocké (Figure 4). Ce n’est qu’au moment de la lecture que le décodeur décompresse le petit fichier afin d’être traduit sur un système d’écoute, et notamment à travers le DAC (Figure 5).

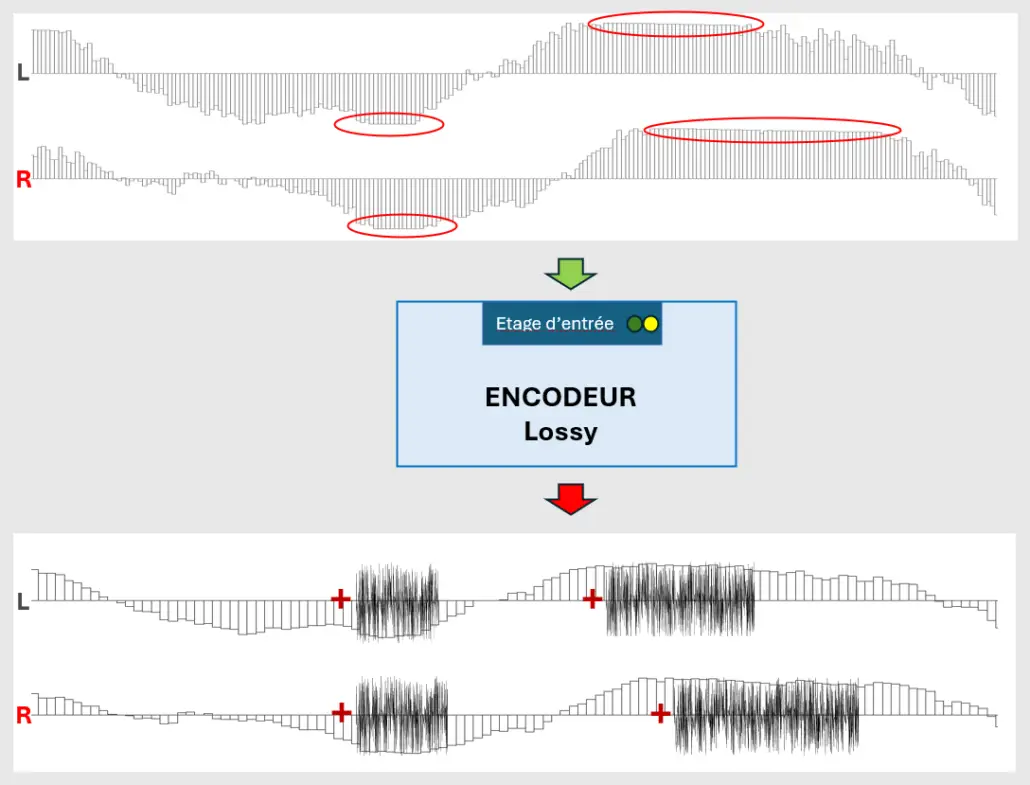

Figure 4 : Création d’un fichier Lossy à partir d’un fichier Master (LPCM). Le terme « Lossy » désigne un format qui subit une perte d’informations audibles par rapport au format brut LPCM du Master. La partie « encodeur » de l’algorithme permet d’obtenir ce fichier « compressé ». Le fichier Master a subi une « compression de données ». Le fichier ainsi créé présente comme seul avantage d’être réduit en poids, l’inconvénient réside sur le fait qu’il perd ses qualités sonores puisqu’il subit une perte de données audibles. Pendant l’encodage, plus le débit binaire appliqué est élevé (bitrate), plus il subit de dommages. Notez que les formats Lossy ne peuvent jamais être représentés à l’inverse du format LPCM.

Figure 5 : Lecture du fichier Lossy. Au moment de la lecture du fichier compressé, le « Décodeur » permet de créer de nouveaux échantillons de nouveau en LPCM, seul langage que les DAC peuvent interpréter en signal continu. Le fichier Lossy est donc décompressé avec ses propres pertes générées pendant l’encodage. Notez qu’une fois le fichier dégradé, il n’est plus possible de retrouver le fichier LPCM de départ car l’encodage Lossy est un processus irréversible. Notez que dans cette représentation réelle du fichier LPCM reconstruit (l’exemple sera étudié plus loin dans l’article), un des échantillons n’a pas pu être créé dans la zone de l’échelle commune. Cet échantillon n’existe donc pas, la reconstruction continue laisse donc place à un True Peak de valeur importante. Ce qui confirme, comme nous allons le voir plus loin, la mauvaise gestion des True Peak lors du décodage des formats Lossy.

L'encodage Lossy

Lors d’une conversion Lossy d’un format LPCM vers un format « avec perte » (comme par exemple le mp3, l’AAC, l’Ogg Vorbis…) des niveaux trop forts du signal peuvent surcharger les encodeurs (Figure 6). En effet, les encodeurs Lossy ont besoin de «marge» (headroom) afin de convertir correctement les données. Quand le signal est trop fort à l’entrée de l’encodeur, celui-ci sature créant une distorsion propre qui se mélange au reste du signal. Ce qu’il convient donc d’éviter si tel n’est pas le but du producteur, artiste ou ingénieur du son au moment du Mastering.

Attention cependant, ces niveaux appliqués à l’entrée de l’encodeur représentent des niveaux d’échantillons (Sample Peak levels) et non des niveaux True Peaks puisque l’opération d’encodage réside entièrement dans le domaine numérique.

En studio de Mastering il s’agit de trouver la meilleure solution « de niveau global et final » pour éviter d’engendrer ce type de distorsion causé par les niveaux les plus hauts du signal.

Figure 6 : Encodage .wav vers un format Lossy. Si le niveau du signal d’entrée est trop fort, l’étage d’entrée de l’encodeur sature et laisse apparaître une forme de distorsion qui se rajoute au reste du signal encodé.

Le décodage Lossy

Une fois les Masters compressés dans leurs formes « Lossy », il faut donc aussi s’assurer que les nouveaux échantillons créés via le nouveau format n’engendrent pas de niveaux True Peaks provoquant du Clipping au moment de la lecture à travers le DAC utilisé. Car en effet, si le signal est modifié à cause du caractère destructeur de l’encodeur Lossy, les échantillons du signal changent obligatoirement de valeurs au sein de l’échelle numérique. Ces nouvelles valeurs peuvent tout à fait induire des niveaux True Peaks. (Figures 7a, 7b, 7c, et 7d).

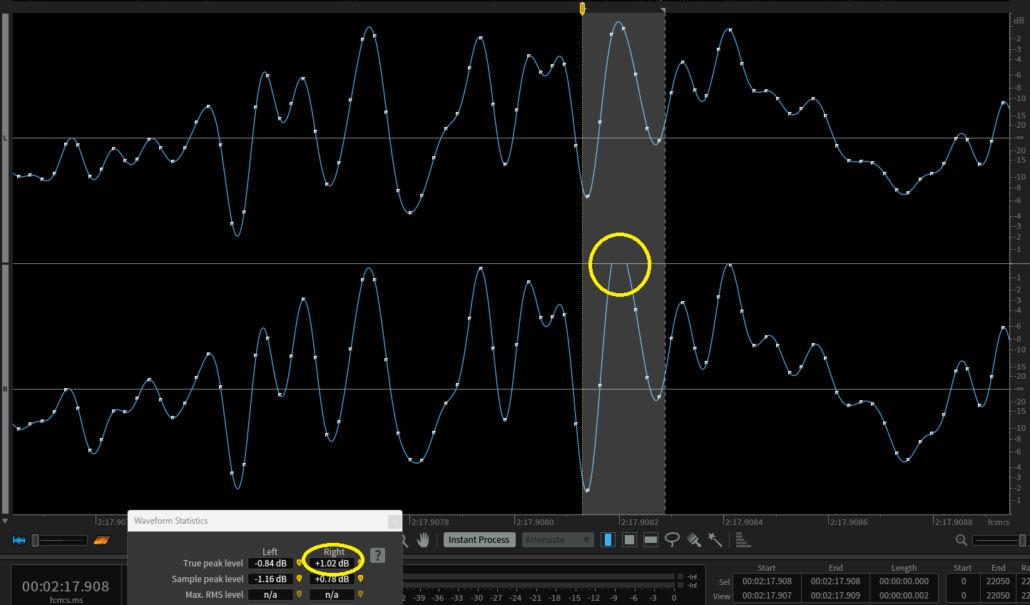

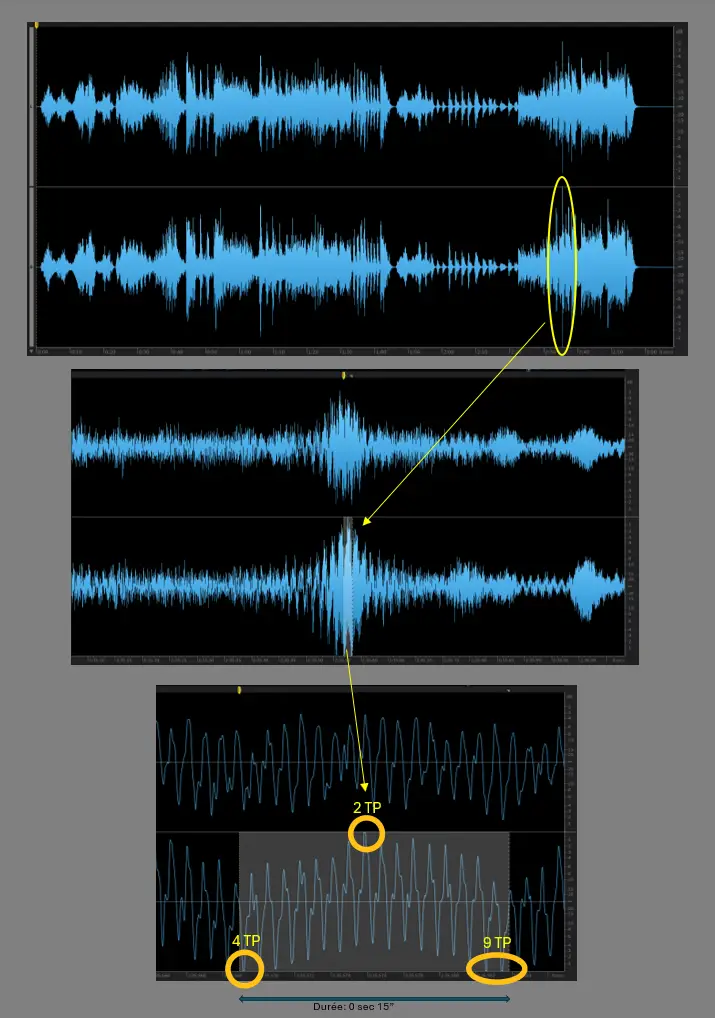

Figure 7a: Sur RX (iZotope), représentation d’une partie d’un fichier audio LPCM issu d’un CD-Audio (Michel Jonasz, Joueurs de Blues, région zoomée autour de 2min 17sec 908).

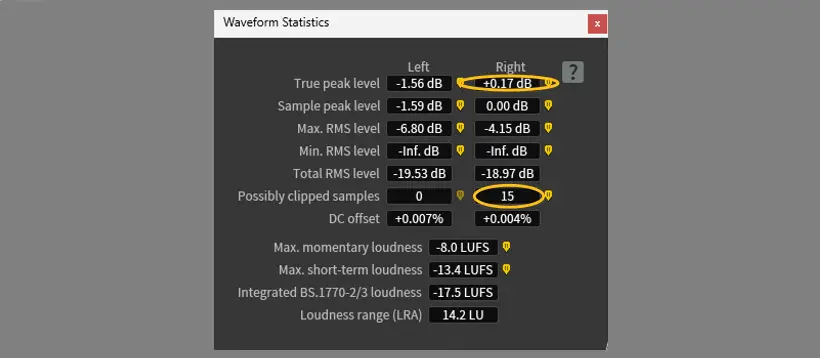

Figure 7b: Représentation de la même partie du fichier Audio, après l’encodage Lossy du fichier d’origine représenté plus haut, en utilisant un bitrate faible, donc un fichier très compressé (Ogg Vorbis, Bitrate=64kbps (Q=0)). Vous noterez la présence d’une valeur True Peak très importante sur le canal de droite (+1.02dBTP), alors que pour la même valeur de temps, sur le canal de gauche la nouvelle valeur de l’échantillon a baissé. Cela s’explique par la nouvelle répartition des échantillons au sein de l’échelle numérique.

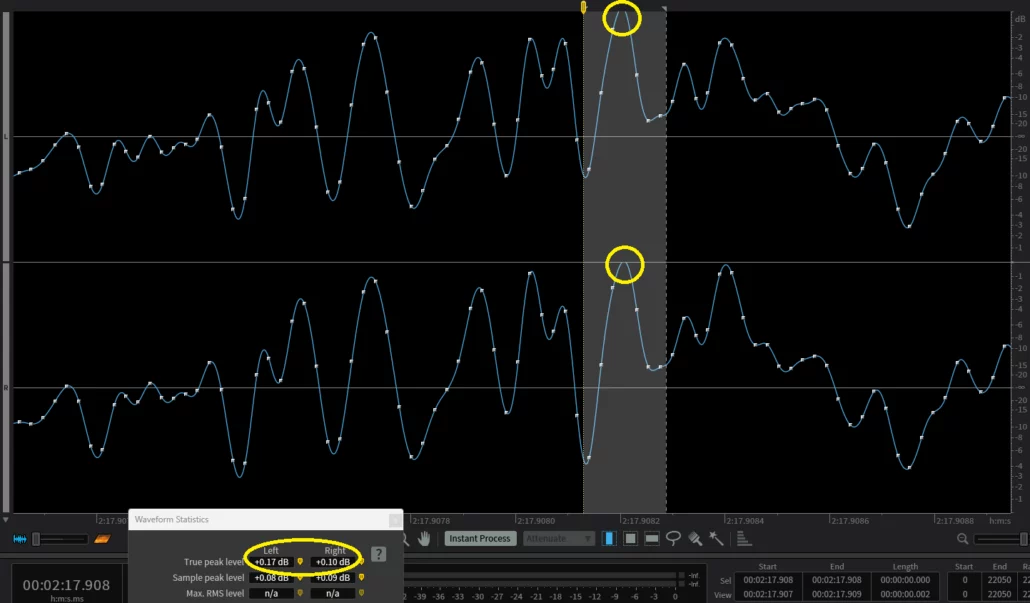

Figure 7c : Représentation de la même partie du fichier Audio, après un encodage Lossy Ogg Vorbis du fichier d’origine, mais cette fois avec la qualité maximale d’encodage (Q=10 c’est à dire un Bitrate=500kbps). Malgré la valeur très élevée du bitrate, vous noterez tout de même la présence d’une valeur True Peak modérée sur chacun des canaux (Canal de gauche: +0.17dBTP et Canal de droite: +0.10dBTP). Ce résultat s’explique comme dans le cas précédent par la nouvelle répartition des échantillons au sein de l’échelle numérique.

Notez que sur la Figure 4c au niveau du True Peak un échantillon est manquant. En effet, en LPCM on devrait pouvoir localiser un échantillon à chaque pas numérique, or ici l’algorithme reposable du Décodage a été incapable de déterminer d’échantillon dans la zone de l’échelle numérique, ce qui manifestement crée cette valeur True Peak dans la reconstruction du signal.

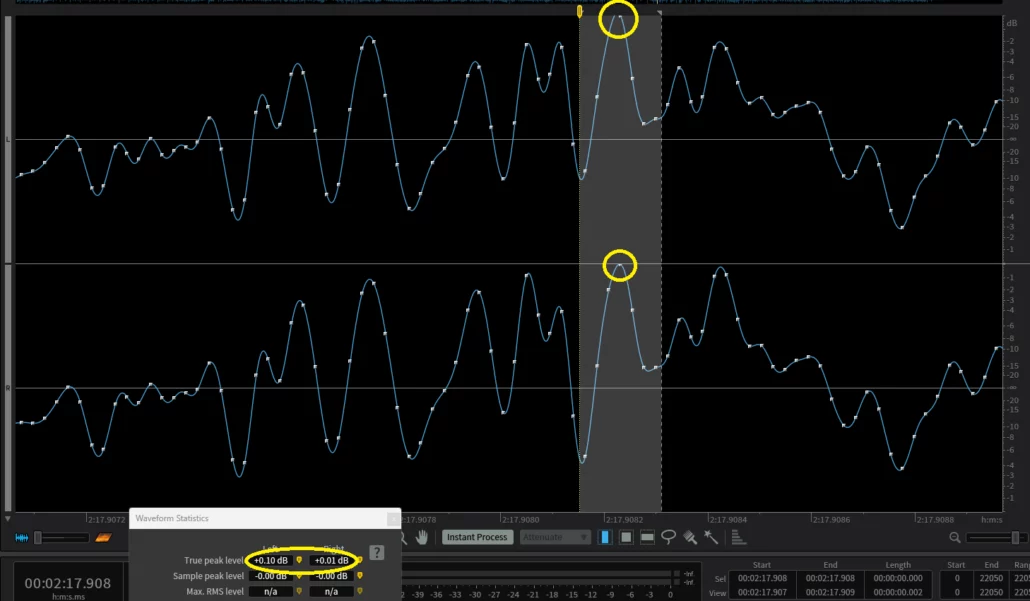

Sur la Figure 4e, Notez aussi que sur la représentation du fichier d’origine (Cd-Audio), les deux valeurs concernées représentent des valeurs True Peaks mais presque invisibles: Canal de gauche: +0.10dBTP et Canal de droite: +0.01dBTP.

Figure 7d

Dans le morceau concerné, l’analyse montre qu’il y a au total 61 True Peak dépassant le maximum numérique (15 pour le canal de gauche et 46 pour le canal de droite) (Figure 7e). Ceci s’explique par le fait qu’à l’époque de la sortie de cet album en Cd-Audio (la version présentée concerne la première édition en format CD, sortie en 1986) les ingés-son de mastering ne se souciaient jamais des valeurs du True Peak. Comme le volume moyen étant réellement bas (-15,5LUFS) et la dynamique importante, ces valeurs de True Peak n’étaient pas gênantes. Bien au contraire, les productions actuelles dans les genres plus « Mainstream » sont plus sujet à poser des problèmes d’interprétation des Trues Peak, puisque les volumes moyens sont beaucoup plus importants, compte tenu de la surcharge des DAC et aussi des surcharges de niveaux pendant les encodages Lossy.

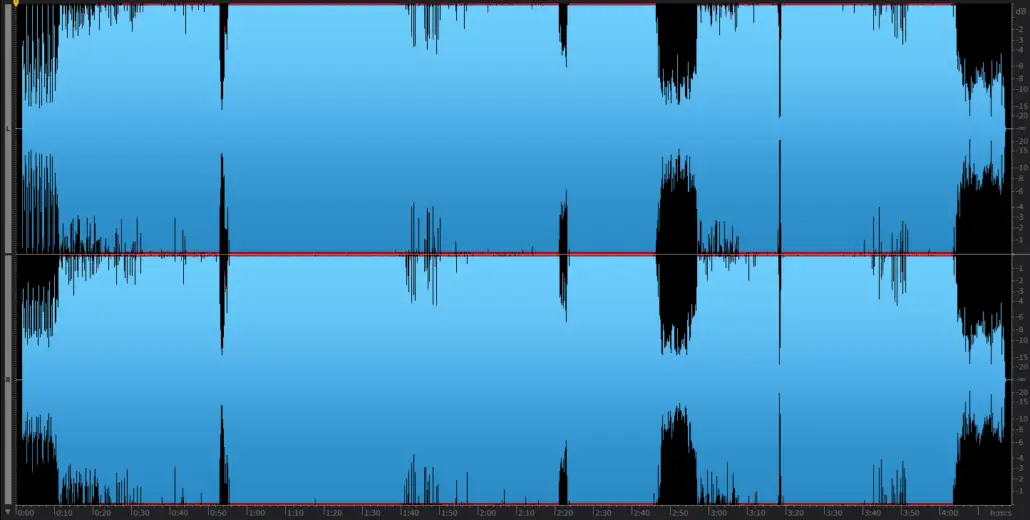

Figure 7e: Représentation de la forme d’onde du morceau entier « Joueurs de Blues » . Album « La nouvelle vie », Michel Jonasz. Album sorti en 1981 (Vinyle et Cassette Audio). La numérisation des bandes magnétiques pour permettre la sortie de l’album en CD-Audio a eu lieu entre 1984 et 1985. Notez la dynamique du morceau (la différence entre les bas niveaux et les forts niveaux), et les valeurs True Peaks occasionnelles reportées dans l’analyse du fichier.

Résumé des problèmes posés par le True Peak

Les valeurs True Peak excédants le maximum numérique présentent un problème d’interprétation lors de la lecture à travers les DAC qui saturent, surtout si ces derniers sont de piètre qualité.

Les True Peak présentent aussi de nombreux problèmes lors du décodage après une conversion Lossy, car les échantillons sont entièrement recalculés avec des valeurs pouvant largement dépasser les valeurs True Peak de départ du fichier d’origine. Ces dépassements sont très liées à la valeur du bit rate appliquée pour la conversion. Ils sont aussi très dépendants du niveau des échantillons du fichier de départ si ceux-ci trop élevés.

La difficulté du True Peak pour les Plateformes de Streaming

Les limites du Streaming

Aujourd’hui en 2025 en moyennant un abonnement, la majorité des plateformes propose leur catalogue de musique en qualité LPCM .wav standard, minimum 16bits et 44,1kHz (qualité du Cd-Audio) et très souvent en Haute Résolution dans le même format livré par les studios de Mastering, comme par exemple en .wav 24bits et 44,1kHz, 48kHz, 96kHz, etc… Or ces plateformes, au delà du fait qu’elles soient capables de fournir la majorité de leur catalogue en Haute Résolution, fournissent aussi en parallèle un format Lossy a leurs abonnés. En effet, selon les usages « grand public » les abonnés doivent se contenter du format Lossy lors d’un usage nomade (par exemple écoute à travers le Smartphone) puisque ce format est moins contraignant à lire dans les conditions limitées en bande passante et en poids de fichier Lossy. Aussi bien sûr, la mauvaise qualité du format Lossy est moins identifiable à travers des petits systèmes d’écoute à cause principalement de la réponse fréquentielle qu’il renvoie.

Il faut bien comprendre que le Codage réalisé à partir des Masters studio (couramment des fichiers .wav 24bits min @44,1kHz) n’est jamais réalisé en Mastering. Les fichiers Lossy proposés par les plateformes sont automatiquement encodés par elles-mêmes à partir des fichiers qu’on leur envoie, ce qui peut poser des problèmes de clipping résultant d’une mauvaise gestion des niveaux trop forts à l’entrée de l’encodeur, et donc par conséquent aussi des niveaux True Peak non contrôlés.

Seul les professionnels du Mastering sauront finaliser des Masters dont l’encodage et le décodage n’induiront pas de de distorsion audible due à des niveaux non contrôlés. On concrétise ainsi des Masters « propres » dans lesquels ce type de distorsion ne peut se rajouter de facto aux artefacts liés à la perte d’information lors du passage au format Lossy.

Outre les transformations « avec perte » qui s’opèrent au sein même des Plateformes de Streaming, les transformations Lossy peuvent aussi être réalisées par quiconque étant muni d’une application le permettant. Comme par exemple quand on converti de chez soi un fichier .wav en fichier .mp3 à l’aide de l’application « Music » (Apple) ou de l’application tierce « VLC » pour Windows. Dans ce cas le codage peut devenir de mauvaise qualité puisque l’utilisateur ne peut contrôler les niveaux à l’entrée de l’encodeur pour éviter les surcharges. Aussi, l’utilisateur ne peut pas contrôler les niveaux True Peak créés pendant le processus du décodage.

Figure 7: L’application « Apple Music » pour macOS qui a remplacé iTunes en 2019, et l’application « VLC » pour PC sont les programmes qui sont le plus utilisés aujourd’hui pour permettre aux utilisateurs d’encoder eux-mêmes des fichiers audio LPCM en format Lossy.

Les Recommandations True Peak Max

Pour remédier à ce problème de niveau True Peak qui s’aggrave avec le codage et le décodage de type « Lossy », les plateformes recommandent des Masters dont les valeurs True Peak ne dépassent pas le seuil de -1dBFS (Cf Figure 8). Il s’agit de la même recommandation imposée dès 2010 par l’EBU pour la branche de l’audio « Broadcast et Mixage TV » (EBU R 128). A noter que seul Spotify recommande la valeur de -2dBTP si les titres masterisés dépassent la valeur « Loudness Intégrée » de -14LUFS. En effet Spotify est aujourd’hui encore une des seules plateformes de Streaming qui délivre l’audio codé « avec perte » (format Lossy Ogg Vorbis au bitrate entre 160 et 320kbps selon les abonnements). Il n’est donc pas illogique qu’il faille rajouter une marge de sécurité supplémentaire de -1dBTP pour que leur Codec fonctionne idéalement en évitant la création de True Peaks gênants.

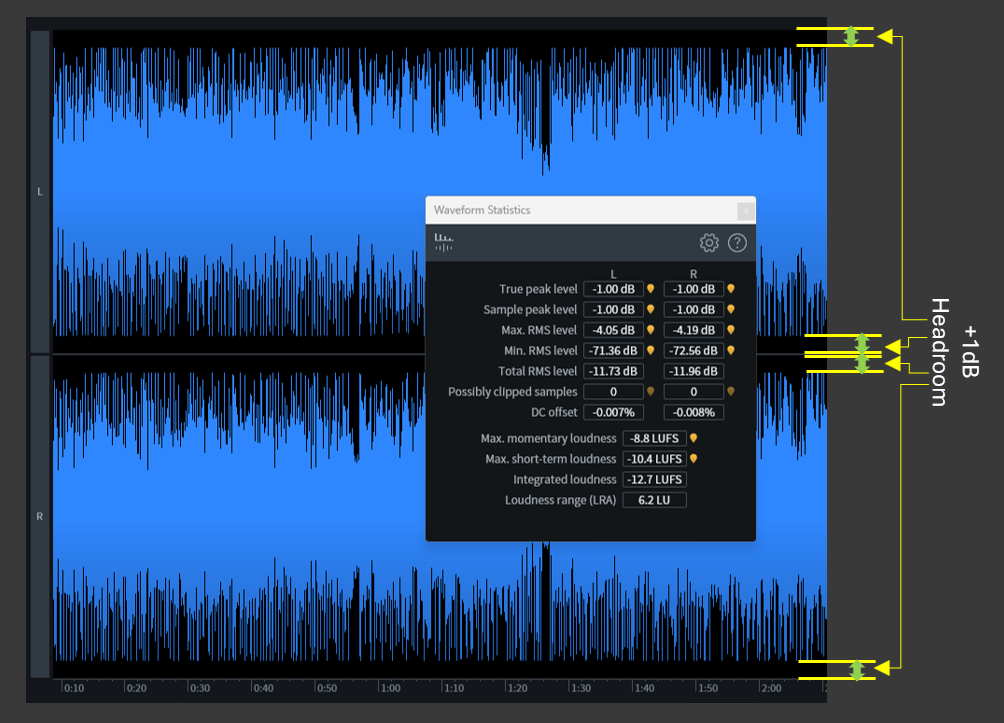

Figure 8 : Exemple d’un master: on lit une valeur True Peak Max qui atteint -1dBTP conformément à la recommandation EBU R 128. Ce qui représente une marge de niveau (Headroom) de 1dB évaluée entre les niveaux du signal « maximum True Peak » et le maximum numérique (0dBFS). Si on devait masteriser exclusivement pour Spotify en suivant leurs recommandations, il faudrait réduire le niveau global du Master de 1dB supplémentaire soit 2dB de Headroom ! …alors que si leur politique changeait en faveur d’un catalogue en Lossless, nous ne serions pas obligés de réduire ce niveau et la qualité des musiques seraient enfin légitimes.

Le constat "True Peak" selon les genres

Le cas des musiques dynamiques

En revanche, notez que le contrairement au domaine du Broadcast pour lequel les niveaux maximum établis sont réellement appliqués, dans l’Industrie de la Musique il n’existe aucune règle ni aucune obligation. Aucun organisme ni dispositif refusera un Master si son niveau True Peak est trop élevé. Aujourd’hui dans le domaine de l’Industrie de la musique on parle de «recommandations » au sens premier du terme. Selon les cas ces recommandations ne sont pas toujours suivies.

La présence de valeurs « TP » occasionnelles et dont l’amplitude demeure faible (par exemple : 3 ou 4 valeurs TP @+0.3dBFS dans l’ensemble du morceau) ne présente pas de difficulté, puisque la distorsion engendrée durant le décodage / DAC demeure soit très faible, soit très ponctuelle et donc dans les deux cas elle passerait inaperçue. On peut aussi trouver des albums pour lesquels seuls 1 ou 2 titres sur un ensemble de + de 10 titres comportent quelques True Peaks qui peuvent être gênants, donc en particulier lors de la lecture via des convertisseurs DAC très courants, donc non performants.

Dans l’exemple du morceau suivant de musique Classique (Figures 9 et 10) nous notons 15 valeurs True Peak sur le canal de droite. Celles-ci sont concentrées dans une région entre 2:35.569 et 2:35.584 soit dans un intervalle très court de 15 centièmes de secondes. Donc à cet endroit et selon la qualité du DAC utilisé, l’oreille pourrait distinguer une distorsion générale qui englobe les 15 valeurs TP à la fois.

Sur cet album très réussi de 18 titres dont provient l’exemple étudié, seuls deux titres posent un problème True Peak dépassant le Full Scale. Ces dépassements n’ont manifestement pas été considérés pendant le Mastering.

Figures 9 et 10 : Vivaldi Concerto l’Inverno n.4 Allegro – Le Quattro Stagioni – Interpreti Veneziani (Cd-Audio, In Venice Sound, 2013).

La Guerre des Volumes comme point de départ

Aujourd’hui il n’est pas rare que des productions musicales se masterisent sans tenir compte de ces niveaux True Peak ou bien que la présence des True Peaks dépassant le 0dBFS soit encore élevé. Le sujet de la « Guerre des Volumes » à son apogée dans les années 2000 est plus ancien que la mise en place des outils pour les contrôler dans les studios. Les conséquences de la Guerre des Volumes à cette époque étaient néfastes car le phénomène poussait les studios du Monde entier à tirer parti des technologies pour augmenter le + possible l’amplitude du signal gravé dans le fichier, et donc d’engendrer des valeurs True Peak très importantes (Figures 11, 12 et 13) :

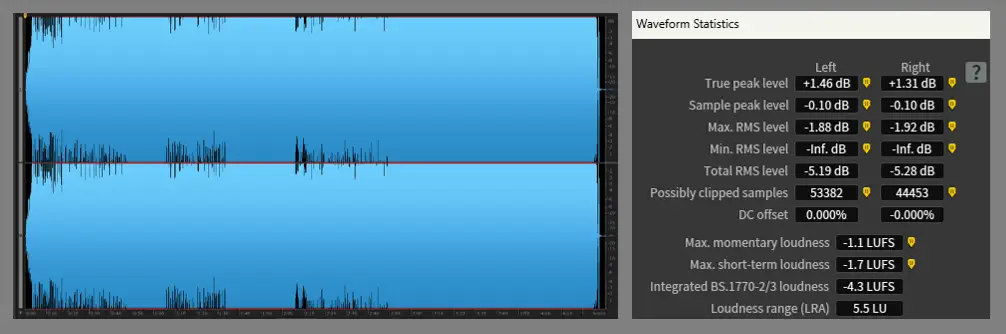

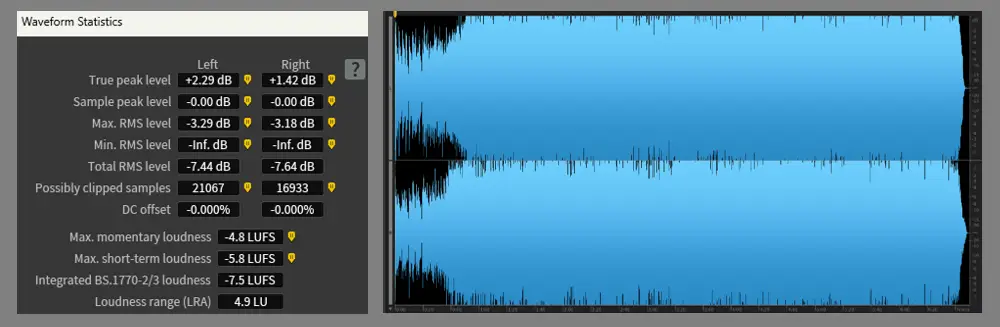

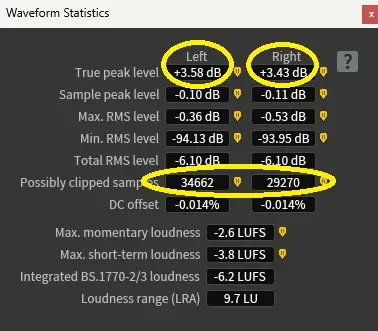

Figure 11 : Analyse: Red Hot Chili Peppers_Parallel Universe (Album « Californication », Warner,1999)

Figure 12 : Analyse : Iron Maiden_Ghost of the navigator (Album « Brave New World », Emi, 2000)

Figure 13 : Analyse : Madonna_Let it will be (Album « Confessions on a dance floor », Warner Bros, 2005)

L'héritage de la Loudness War: l'Affirmation des Codes Mainstream

Aujourd’hui si la tendance depuis les 15 dernières années a été de produire des musiques plus dynamiques qu’avant, il n’en reste pas moins que certains genres de musique persistent à être produit très fort, même si le « Loudness Normalization » perdure. Dans ce cas, ceci grâce à la technologie numérique qui s’accroit continuellement, les valeurs du Loudness peuvent malgré tout et selon les artistes largement dépasser celles d’il y a 20 ans.

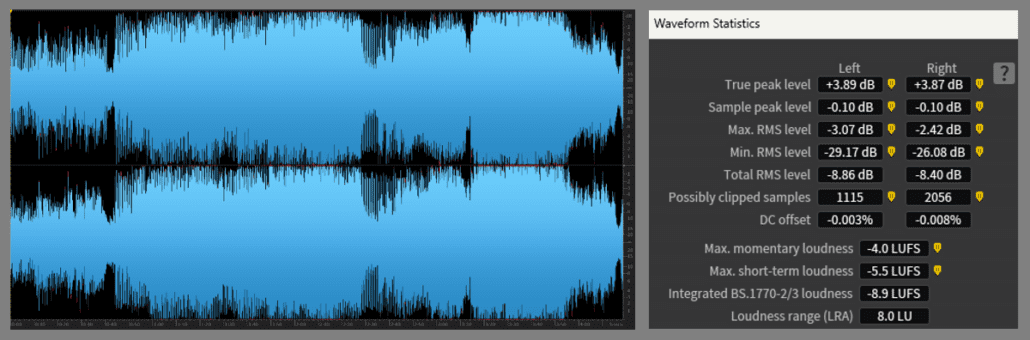

Cette Guerre des Volumes n’est pas sans conséquences dans le domaine de la créativité puisque les 10 premières années d’influence ont fini par créer des codes au sein des genres. La distorsion engendrée dans les productions sonores fait parfois bel et bien partie d’un héritage artistique revendiqué. La majorité des artistes « Mainstream » conçoivent leur musique de manière impactante grâce notamment à l’usage et la gestion de plusieurs formes de distorsion, dont aussi celle engendrée par les niveaux True Peak impactant la lecture des sons. En effet, les producteurs des musiques Pop, Electro, Urbaines ou Rock persistent souvent à dire que le Loudness doit vivre avec son temps, qu’il doit faire partie de cet héritage culturel pour lequel la distorsion peut faire partie de l’art comme forme d’expression (Figure 14).

Assurément dans certains genres la distorsion créée dans les productions est parfaitement intentionnelle. La distorsion générée par le True Peak est un exemple qui peut s’additionner avec d’autres types de distorsion crée par d’autres moyens: les générateurs d’harmoniques (exciters), les compresseurs ou les limiteurs… Cette recherche pour atteindre un niveau d’enregistrement plus fort et compétitif peut sembler excessive, mais elle demeure dans certains cas parfaitement intentionnelle et légitime. Il incombe au(x) technicien(s) du Son de livrer une musique pour laquelle ces distorsions engendrées valorisent le projet dans des intentions définies, et non l’inverse.

Figure 14 : Ragga Bomb (Artiste Skrillex, Album « Recess », Owsla/Big Beat Records, 2014). Sur cet exemple comme dans de très nombreux cas en musique Pop (ou autres) on compte 56 012 True Peaks sur le seul canal de gauche, le plus élevé atteint +3.58dB ce qui est énorme. Dans cet exemple le choix de l’artiste est entièrement intentionnel.

The problem with the loudness war is distortion. When you push levels beyond what the medium can handle, distortion is the result. (...) The clipped sound has become part of the signature of modern mastering — not because it is better, but because people have become accustomed to it..

Bob Katz, ingé-son Mastering

Source : Mastering Audio: The Art and the Science, 3e édition (Focal Press), chapitre sur la Loudness War et chapitre sur le clipping numérique. Dans son livre l’auteur affirme que la distorsion demeure la cause du phénomène de la Guerre des Volumes (ie des niveaux moyens trop forts). Il partage aussi le fait que les générations actuelles se sont habitué à la distorsion. Ce qui expliquerait les intentions artistiques.

“Clipping is just another sound. Whether it’s appropriate depends entirely on the musical context.”

Dave Collins, ingé-son Mastering

Source : Gearspace Q&A avec Dave Collins (thread public — ingénieur présent lui-même).

The biggest issue with hot levels isn’t volume — it’s the distortion they bring.

Dave Collins, ingé-son Mastering

Source : Interview Tape Op Magazine (édition numérique).

Some styles need to sound dirty, gritty, saturated — that’s the vibe, that’s the art.

Maor Appelbaum, ingé-son Mastering

Source : Interview Sonic Scoop, “Inside the Mastering Mind: Maor Appelbaum”.

If an artist wants intensity, sometimes harmonics and saturation are part of achieving that.

Maor Appelbaum, ingé-son Mastering

Source : Masterclass Maor Appelbaum – Pensado’s Place (épisode invité).

Le True Peak ignoré dans le "Loudness Intégré"

Dans les années 2010 le « Loudness Normalization » a été mis en place dès l’essor des plateformes de Streaming. C’est grâce à l’élan mené par l’EBU qui dès 2010 comptait uniformiser le niveau des programmes diffusés dans le Broadcast. De la même manière l’objectif des plateformes visait de réduire les écarts de niveau au sein des playlists puisque les musiques ne sont jamais masterisées avec le même niveau de « Loudness »: Aucune règle imposant des valeurs de « niveaux » n’a jamais existé dans le domaine de l’enregistrement sonore. Des musiques sont ainsi créées plus fortes que d’autres. Donc dans un soucis de confort d’écoute, grâce à cette option de « Normalisation du Loudness » qui baisse le gain des musiques « fortes », toutes les musiques en Streaming sont jouées à peu près « au même niveau » et ce, quelque soit les valeurs ISP même si elles dépassent le 0dBFS.

De surcroît cette pratique ambitionnait de mettre fin à la Guerre des Volumes. En effet un Master possédant un Loudness « trop fort » est d’autant plus baissé que son Loudness est fort. Plus sa valeur de « Loudness Intégrée » est élevée, plus la réduction de gain qu’il subit est importante. Cette baisse de niveau atteint une valeur « cible » qui est définie par la plateforme. De cette façon on décourage donc la pratique de produire de la musique avec un niveau de « Loudness » trop élevé.

Pourtant la notion de True Peak est complétement ignorée dans le calcul du « Loudness Intégré » : le Loudness défini par l’ITU n’intègre pas l’existence des ISP. Par conséquent la « Normalisation du Loudness » n’en tient pas compte. Donc au moment du Mastering, le contrôle des valeurs True Peak n’a aucune conséquence sur « uniformisation du gain » au sein des plateformes. Néanmoins compte tenu des distorsions engendrées par des valeurs True Peak excessives lors de la lecture du signal dans les systèmes de lecture courants ou de mauvaise qualité, le Loudness perçu est en principe impacté, même si le Loudness Intégré ne tient pas compte des valeurs True Peak. En effet, une distorsion ajoutée à un signal augmente forcément la quantité du Loudness perçue: dans ces conditions nous percevons le signal « plus fort ».

La gestion du True Peak

A la fin du process de Mastering, une des préoccupations des ingés-son est de vérifier les valeurs maximales True Peak du signal de tous leur masters: la valeur la plus élevée qu’ils franchissent et de la quantité que ces True Peak incombe. A travers nos écoutes et nos outils audionumériques dédiés on est ainsi capable d’évaluer leur gène lors du Clipping tant en lecture (DAC) que sur les transformations Lossy vouées à être opérées (encodage et décodage).

La detection du True Peak "Max" en Mastering

En studio de Mastering au moment de finaliser les Masters pour le client, on prête une double attention sur ces valeurs TP Max pour les deux raisons citées. au bon déroulement de ces deux opérations de « compression » et de « décompression » des données. De sorte que si les Masters devaient subir un encodage/décodage de type « Lossy », nous éviterions les effets de distorsion provenant de niveaux numériques trop importants.

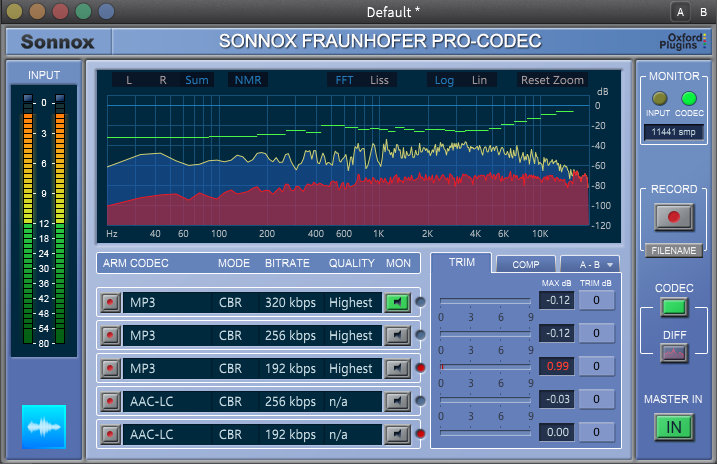

Il existe des outils professionnels qui permettent d’ajuster le niveau du signal à encoder en fonction du Codec et du Débit Binaire choisis. En effet tous les Codecs ne se valent pas: pour une même surcharge de signal certains Codecs génèreront moins de distorsion que d’autres, et le résultat est aussi très dépendant du Débit Binaire considéré (le Bitrate). Effectivement, plus le bitrate est élevé, moins le signal subit de dégradation et moins la quantité de distorsion émergera au moment des surcharges. Comme exemples d’outils qui nous permettent de contrôler la surcharge des niveaux LPCM à l’entrée du codec, nous avons l’excellent Fraunhaufer Pro-Codec (Sonnox) (FIgure 15), ainsi que les outils fournis par Apple à travers le programme « Apple Digital Masters.

FIgure 15 : le plugin « Fraunhöfer Pro Codec » (Sonnox ) analysant en temps réél de lecture différents flux d’encodage/décodage en fonction des Codecs et bitrates choisis (ici analyses du mp3@320kbps, 256kbps, 192kbps et AAC@256kbps et 192kbps). On note ici que le Master clipperait le codec mp3 avec une valeur True Peak Max de +0.99dB si on utilisait un bitrate de 192kbps. Pour tous les autres exemples le codec ne génére aucun True Peak génant.

Le True Peak aujourd'hui n'est pas toujours une simple formalité

Le Mastering a pour finalité de bonifier le message artistique et de rendre l’ensemble du projet cohérent et compétitif. Il a aussi comme objectif de livrer des Masters qui ont l’avantage d’être correctement traduits sur toutes les gammes de systèmes d’écoute. Du système de reproduction courant au système le plus performant. Les studios de Mastering œuvrent pour garantir cela avec entre autre le contrôle des niveaux True Peak. L’expertise des ingénieurs du son dont la spécialité est le Mastering Audio, repose sur l’élaboration d’un vrai travail de traitement du signal afin d’améliorer le rendu des sons qu’on leur confie et pour lequel ils sont largement sollicités.

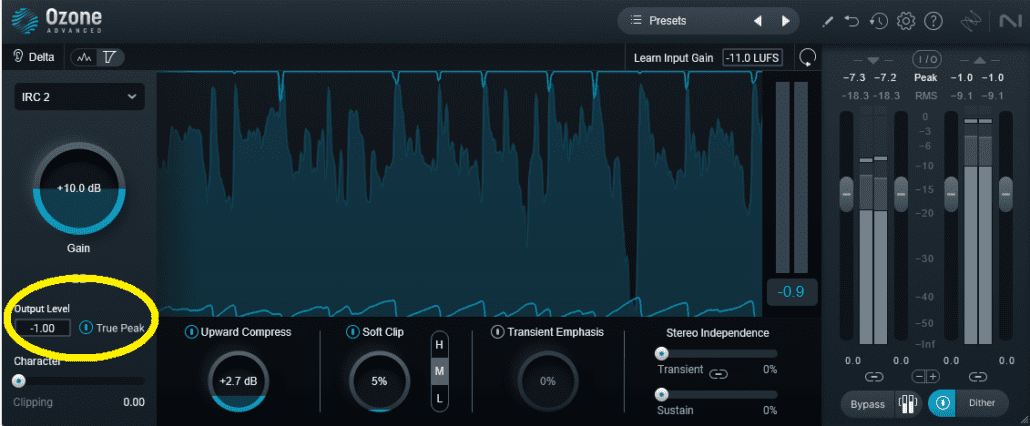

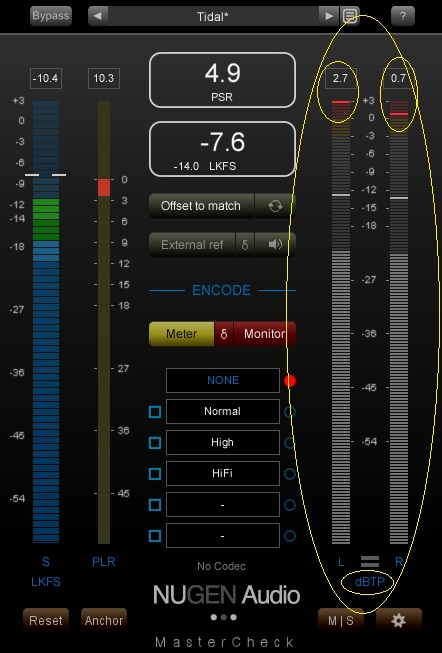

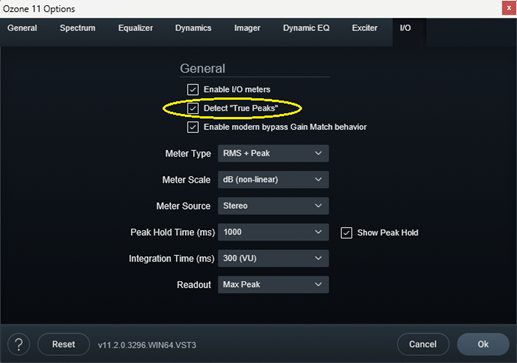

Aujourd’hui tous les programmes audionumériques permettent de visualiser les niveaux True Peak maximum d’un signal. Dans le cas où nous jugeons important de créer un headroom de -1dBTP sur les masters, nous utilisons des Limiteurs de type Brickwall qui possèdent une fonction de détection True Peak (Figures 16, 17 et 18). Dans ce cas de figure et quand cette fonction est enclenchée le limiteur détecte ainsi tous les niveaux (niveaux des échantillons et niveaux ISP) et réduit le signal en conséquence, dès qu’il dépasse le seuil déterminé par l’utilisateur. De cette sorte on garanti un signal exempt de niveaux TP qui seraient problématiques lors de la conversion DAC. Cependant l’activation de cette fonction sur le limiteur n’est pas toujours sans effets secondaires dans le son. Avec le mode TP engagé certains limiteurs colorent le signal d’une certaine façon. Alors que d’autres limiteurs se comportent de manière beaucoup plus transparente. Mais la coloration du signal peut, comme par l’utilisation de n’importe quel autre outil de traitement, demeurer intéressante selon l’intention recherchée. Tout travail de Mastering professionnel est basée sur des intentions de transformation du signal perçu, et les choix se basent sur les spécificités du signal tel qui se présente. Dans le cas où le « True Peak Limiting » s’avère appauvrir le signal, nous cherchons d’autres solutions: on utilise un autre limiteur ou d’autres outils qui donneront de meilleurs résultats en fonction du signal considéré. On peut aussi ignorer la fonction True Peak et ajuster le niveau des Masters en contrôlant visuellement les niveaux à l’aide d’un mètre True Peak dédié (Figures 19 et 20).

Figure 16: Exemple avec l’excellent Limiteur Brickwall « Invisible Limiter G3 » (A.O.M) qui contrôle les niveaux True Peaks après la section Limiting du plugin de sorte qu’ils ne dépassent pas la valeur définie par l’utilisateur. Ici cette valeur est représentée par le « Threshold » fixé à -1.00dB(FS). Dans cet exemple en cliquant sur « True Peak Aware » on a donc une garantie qu’aucun ISP ne dépasse -1dBFS. On note donc le niveau maximal du signal « -1dBTP ».

Figure 17: Exemple avec le Limiteur Brickwall de la suite Ozone (iZotope) sur lequel le gain d’entée est fixé à +10dB. La fonction « True Peak » a été enclenchée en bas à gauche. Le niveau de sortie du plugin « Output Level » est fixé à -1.00dB, ce qui signifie qu’en sortie du plugin les niveaux True Peaks maximums du signal atteignent -1.00dB (-1dBTP).

Figure 18 : Autre exemple avec le Limiteur Brickwall TDR Audio « Limiter 6 GE ». Configuration identique: Gain@+10dB, Seuil@-1dB configuré en détection True Peak et non simplement « PCM » qu’on peut apercevoir sous « True Peak » au milieu. On peut lire sur le mètre en bas à droite que le niveau du signal atteint jusqu’à -1.0dBTP.

Figure 19 : Exemple de mètre « True Peak » avec le plugin Mastercheck de Nugen Audio. Cet outil ne transforme pas le signal, il ne sert qu’à visualiser les niveaux du signal.

Figure 20 : Autre exemple pour la configuration des mètres en « True Peak » sur la réglages d’Ozone (iZotope).

Pour un signal donné les plugins affichant la mesure des ISP ne présentent pas toujours les mêmes valeurs: elles peuvent être légèrement différentes. Ceci est principalement dû au choix de sous-algorithmes de calculs comme par exemple des fonctions de suréchantillonnage (oversampling) qui ne présentent pas toujours les mêmes caractéristiques. Ainsi qu’aux différentes mises à jour du programme de mesure établi par l’ITU. Le programme de calcul des True Peak est notamment basé sur des techniques d’oversampling et de filtrage (filtre de lissage) démontrées par l’ITU dans la dernière version de Novembre 2023: ITU-R BS.1770-5. Cependant les méthodes de calcul des ISP n’ont pas évolué depuis la version 3 du document aboutissant aux recherches de la société, sorti en Août 2012: ITU-R BS.1770-3.

Le True Peak "avant": d'inutile à problématique

Même si le contrôle des niveaux True Peak demeure une pratique courante en Mastering professionnel, ce n’était pas le cas avant les années 2010, car nous n’avions pas les moyens suffisants pour les mesurer précisément ni de pouvoir les contrôler de manière efficace. Aussi, les habitudes liées à la Guerre des Volumes ont ralenti la volonté de remise en question des conséquences de ces True Peak.

Dès l’arrivée du CD-Audio (1982) les niveaux gravés étaient très inférieurs à ceux pratiqués à la fin des années ’90 (Figure 21). A l’époque on ne se souciait jamais de des valeurs ISP. En effet, globalement sur un CD produit entre 1982 et 1990 les niveaux de crête les plus hauts se situaient à plusieurs dBs du Full Scale, rendant impossible les surcharges des DACs de l’époque. Dans les années 1980/1990 on parle de « l’âge d’Or du CD ». Il est bon de rappeler que le Cd-Audio fut le premier format audionumérique créé, la notion de True Peak naissait à ce moment là mais ses conséquences se sont donc posées que 15 ans plus tard.

Figure 21 : Analyse de Rosanna de l’artiste Toto. Version originale de l’album CD Toto IV, non remasterisée, Columbia records, 1982. Les True Peaks les plus hauts ne dépassent pas -2.19dBFS ce qui laisse un Headroom conséquent et évite ainsi de surcharger tout DAC. Cela permet aussi de directement générer des formats Lossy de meilleure qualité.

Le paradoxe de la technologie

Aujourd’hui étant donné la facilité d’accès à la musique de façon nomade, en particulier avec l’utilisation des smartphones connectés, la consommation de la musique s’est largement détériorée puisque dans ces conditions nous ne sommes plus capables de pouvoir apprécier la musique dans sa juste valeur. En effet, à travers un objet de la taille d’une main, tout le système audio est contenu: le lecteur audionumérique (le « Player »), le DAC, l’amplification et le(s) haut-parleur(s). Le système est minimisé pour réduire le coût de production. Par conséquent le DAC et les Haut Parleurs d’un Smartphone demeurent obligatoirement de piètre performance. A moins d’utiliser son Smartphone pour l’utilisation du Player et de router le signal audionumérique sur un DAC externe décent, cette technologie nomade ne peut restituer la musique de manière qualitative.

Malgré la qualité de la musique enregistrée dans le cas d’une production exemplaire et d’un format de fichier de type LPCM (Lossless), avec son téléphone on perçoit donc une musique dénuée de toutes ses qualités pourtant présentes dans le fichier « sans pertes »: sa réponse fréquentielle étendue, sa dynamique et la notion d’espace que le cerveau restitue quand on utilise un système d’écoute dans des conditions acceptables. En utilisant un Smartphone pour écouter de la musique la réponse fréquentielle et la dynamique sont étriquées à cause de la faible performance du DAC dans le téléphone et de la taille des Haut Parleurs. De plus en utilisant le Haut Parleur du téléphone la notion d’espace disparaît complètement puisque le sujet ne dispose pas de l’effet stéréophonique produit par une paire de transducteurs.

Force est de constater qu’aujourd’hui les systèmes Hi-Fi ne sont plus autant utilisés qu’à l’époque du Cd, et que les systèmes performants sont souvent inaccessibles pour la plupart des personnes. Pourtant les avancées en terme de technologie sont bien réelles, aujourd’hui nous savons construire mieux que jamais de biens meilleurs DAC, amplis et Haut Parleurs. Que penser de l’avenir de la consommation de la musique quand Mark Zuckerberg le PDG de Meta prédit l’extinction proche des smartphones en introduisant des lunettes permettant les mêmes fonctions ?

Devant ces considérations technologiques le critère de l’aspect qualitatif d’un DAC est invariable puisque le signal audionumérique s’écoute obligatoirement par son intermédiaire. Par conséquent le sujet du True Peak restera d’actualité pour l’auditeur « lambda » si ses habitudes et les moyens qu’il utilise n’évoluent pas.

La conclusion du "True Peak" en Mastering

Cette réalité d’interprétation réelle devrait susciter une certaine forme de prudence au moment du Mastering puisqu’elle peut engendrer une forme de distorsion audible à travers les systèmes courants et que cette distorsion n’est en principe pas désirée. Cette réalité reste entièrement consciente en milieu professionnel. Mais selon la diversité des genres de musiques qui ne sont pas tous rattachés au code hérité concernant le volume enregistré perçu, il est cependant légitime que les musiques Mainstream trouvent leur place dans leur choix artistique.

En Mastering nous sommes soucieux de livrer une musique répondant aux codes existants selon les genres tout en restant compétitif. Ce n’est jamais la notion « True Peak » qui détermine la qualité d’un Master. La réussite d’un mastering repose sur la recherche de l’ensemble des traitements engagés dans une perspective intentionnelle et personnelle qui demande beaucoup d’expérience. Cette recherche abouti à un véritable accomplissement mené de front par l’ingé-son Mastering. Avec son expertise celui-ci œuvre pour améliorer la perception du signal, tout en s’adaptant à l’art et aux exigences du Marché.

Un master qui « sonne fort » n’est pas forcément un mauvais master. Il peut parfaitement bonifier le mixage tout en renforçant une meilleure représentation du genre. Inversement un Master qui répond aux strictes recommandations de la valeur maximale du True Peak à ne pas dépasser n’est pas forcément meilleur, ce simple critère n’est clairement pas suffisant.

Dans la société actuelle la majorité des auditeurs utilisent des systèmes médiocres qui empêchent de restituer correctement les qualités que renferme la musique produite dans les studios. En particulier ces mêmes systèmes sont parfaitement incapables de gérer des niveaux True Peak dépassant un certain seuil, ils sont donc inappropriés. En terme de système d’écoute courants, nous devrions peut-être commencer par changer les habitudes et d’enfin pouvoir s’équiper de manière plus qualitative.

Cependant la résurgence du Vinyle dont les ventes croient continuellement depuis les années 2010 semble démontrer l’engouement croissant pour ce format. Celui-ci, par nature, ne présente aucune difficulté dans la notion du True Peak puisque qu’il demeure purement analogique. Mais de manière intéressante et sans aucun doute le Vinyle prouve une certaine recherche consciente et qualitative dans la manière d’écouter la musique.

LPCM vs DSD: le comportement du True Peak

Le True Peak est intrinsèquement lié au codage LPCM, il est par définition son grand défaut. En effet, dans la représentation analogique du signal à partir d’échantillons légitimement créés dans l’échelle numérique, il existera toujours des cas pour lesquels des échantillons successifs trop élevés créent une forme d’onde analogique restreinte dans son amplitude. Alors que dans la pratique, de manière idéale, elle pourrait être convertie sans distorsion si le signal de départ était réduit ou mieux contrôlé. Comme nous l’avons vu dans cet article au travers des exemples de musique dynamique ou de musique très compressée en mastering, la gestion du True Peak demeurera toujours le point faible dans le modèle LPCM.

En revanche pour le codage DSD (Delta‑Sigma) le problème du True Peak est inexistant. En effet le DSD repose sur la création d’un flux à un seul bit à très haute fréquence: les échantillons se créent successivement selon la position de l’échantillon précédent dans la logique d’un circuit « feedbback ». Ainsi les dépassements inter‑échantillons ne peuvent survenir comme en LPCM. En revanche la faiblesse de la méthode Delta Sigma peut reposer sur des phénomènes de surcharge mais cela relève de mécanismes très différents et propres à cette technologie (modulateur, filtrage).

Cette partie d’article met en relief les différences fondamentales entre les deux technologies de codage du signal numérique, tout en rappelant que le LPCM demeure le standard dans la production musicale. Et c’est bien la raison pour laquelle la gestion du True Peak reste un sujet central.

Lexique du Blog "Les niveaux True Peak"

LPCM : Linear Pulse Code Modulation est le système de codage très majoritairement le + utilisé dans l’audio professionnel ou dans la Hi-FI. On le nomme souvent de manière abrégée « PCM » (Pulse Code Modulation), mais en réalité il s’agit d’un abus de langage. Le terme « Linéaire » signifie que les échantillons crées sont espacés de la même manière ce qui n’est pas toujours le cas en « PCM ». Le LPCM est donc une sous catégorie du PCM. Par exemple, pour de l’audio enregistré à une fréquence d’échantillonnage de 44,1kHz (cas du CD-Audio), toutes les secondes on trouve 44 100 échantillons espacés par pas de quantification réguliers. Le LPCM permet de convertir un son analogique sous la forme d’une suite d’échantillons espacés à une fréquence bien définie (44,1kHz, 88.2kHz, 96kHz, etc…). Le LPCM permet aussi de pouvoir réaliser des transformations à l’aide d’outils audionumériques comportant des processeurs (CPUs) à l’aide notamment de stations de travail (DAW, Digital Audio Workstations). On peut donc traiter le signal LPCM en interne (gains, égalisation, compression, générateur d’harmoniques, etc…). En LPCM le format conteneur le plus rependu est le .wav (Waveform Audio File Format, Microsoft & IBM). Il existe aussi le format .aiff ou .aif (Audio Interchange File Format, Apple), et le .bwf (Broadcast Wave File, EBU).

RMS = « Root Mean Square ». Désigne la Moyenne Quadratique. Le niveau RMS est une application purement mathématique qui représente la moyenne des valeurs d’une fonction par rapport à un paramètre donné dont dépend cette fonction. Pour nous en Audio Pro la fonction considérée est la Forme d’Onde (waveform), c’est-à-dire de l’ensemble des valeurs que la courbe projette en fonction du temps. Ainsi la valeur RMS désigne la moyenne arithmétique de l’amplitude de la forme d’onde qui se propage entre le début du morceau jusqu’à sa fin. Cette moyenne est une valeur assez représentative de l’amplitude réellement perçue par notre appareil auditif qui, dans le cas de formes d’ondes complexes (la musique) ne peut entendre les amplitudes maximales de tous les sons de la forme d’onde.

Loudness Intégré : Integrated Loudness. Il représente la sonie d’un morceaux de musique dans toute sa durée. L’algorithme de calcul tient compte de la non linéarité de l’oreille humaine en fonction des fréquences et des intensités. Il est établi par l’ITU dont les premiers travaux sont publiés en 2006 sous la nom « ITU-R BS.1770 ». Depuis, les travaux de recherches sur l’algorithme sont voués à évoluer afin d’accroitre la précision de la mesure du Loudness Intégré mais peut-être aussi de celle du True Peak.

ITU: International Communication Union ou UIT : Union Internationale des Télécommunications. Basée à Genève (Suisse) c’est l’agence rattachée aux Nations Unies œuvrant pour le développement spécialisé dans les technologies de l’information et de la communication. Entre autre elle établi les normes du secteur des télécommunications.

Full Scale: le Full Scale représente l’échelle numérique, l’unité est le dBFS. La valeur maximale possible est le « 0 » puisque sur cette échelle toutes les valeurs exprimées sont négatives. Le Full Scale désigne aussi la valeur maximale, c’est à dire le « 0 ».

Le marché des DAC aujourd’hui:

Sur le site grand public Son-Video.com

Sur le site La maison du haut parleur

Sur le site spécialisé HiFi.fr

Dans ces liens il s’agit de dispositifs grand public remplissant uniquement le fonction de conversion du DAC (et de pré amplification) mais il existe aussi des systèmes HiFi « multifonctions » dans lequel un DAC est intégré. Par exemple le cas des amplis intégrés ou de certains lecteurs…

Lossy: l’encodage « Lossy » – contrairement à l’encodage « Lossless » – est une compression de données (data)

qui engendre une perte de la partie audible du signal du format d’origine en contrepartie de l’allégement du poids du fichier. L’exemple le plus courant est le mp3 qui malgré l’arrêt de son développement en 2017 par son créateur l’institut Fraunhofer IIS demeure toujours le format Lossy le plus couramment utilisé.

Limiteur Brickwall: le limiteur de type Brickwall est un outil de traitement permettant d’augmenter le niveau sonore du signal tout en empêchant celui-ci de dépasser un seuil numérique défini par l’utilisateur. Le sueil le plus haut possible étant le 0 absolu ou « Full Scale ». En 1994 la compagnie Waves Ltd lance son Plugin « L1 » qui ouvrira le chapitre de la Guerre des Volumes conjointement à la technologie du Cd-Audio introduit en 1982.

Plugin : le plugin est un programme audionumérique qui s’insert au sein d’un programme Hôte appelé « Station Audionumérique » ou « DAW » (Digital Audio Workstation) par lequel les fichiers audio sont traités: égalisation, compression, niveaux etc…

EBU: European Broadcast Union ou UER. C’est l’Union Européenne de Radio Télévision. Comme l’ITU l’organisation est basée à Genève. En s’appuyant sur les travaux de l’ITU conduits depuis 2006 sur les mesures du Loudness et du True Peak, l’EBU publie en Aout 2010 ses propres recommandations sous le nom EBU R 128 : « Loudness Normalisation and permitted maximum level of Audio Signals ». Elles rentrent en vigueur en 2012. L’EBU réalise des mises à jour régulières en lien avec les versions de l’ITU sur les mesures (ITU BS 1770). La dernière version EBU R 128-5 date de novembre 2023.

Utilisation du Smartphone: selon une étude menée par Qobuz en 2021, 72% des jeunes écoutent de la musique avec uniquement leur Smartphone.